Que fait-on quand les scientifiques ont peur de l’IA ?

Que fait-on quand les scientifiques ont peur de l’IA ?Une lettre ouverte signée pour prendre dès maintenant les mesures nécessaires

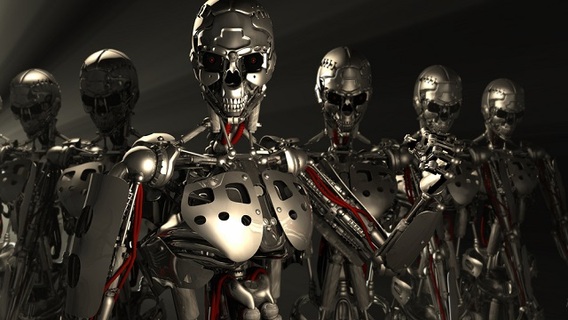

Une récente interview de la BBC avait relancé le débat sur le futur de l’intelligence artificielle après que le célèbre scientifique physicien Stephen Hawking eut exprimé son inquiétude sur ce sujet. Après avoir expliqué le fonctionnement de son système de parole artificiel, il avait confirmé que l’intelligence artificielle n’est qu’au stade primitif et que même si les programmes dits « intelligents » actuels s’avèrent très utiles, il est à craindre de voir un jour les machines se développer tellement vite que l’évolution biologique de l’être humain ne puisse concurrencer le développement croissant des machines, ce qui pourrait amener à l’extinction de la race humaine.

Ce scénario catastrophe, qui revient sans cesse dans les œuvres de science-fiction et de cinéma, ne fait pas l’unanimité chez la communauté scientifique. En effet, le débat existe depuis le milieu des années 50 lorsque Alan Turing, l’un des pères de l’intelligence artificielle, avait posé sa célèbre question « une machine est-elle capable de penser ? ».

Si on analyse les programmes dits « intelligents » d’aujourd’hui sur un plan scientifique, les machines sont loin de pouvoir penser et ressentir des émotions. Même les techniques évoluées « d’apprentissage machine » ne font à la base que des calculs plus ou moins complexes pour adapter leur fonctionnement selon un certain critère établi par le programmeur. On trouve maintenant des voitures autonomes testées en situation réelle, des robots qui peuvent apprendre des nouveaux comportement en observant et reproduisant les gestes des hommes, des systèmes prédictifs qui analysent l’évolution du marché et prédisent les éventuels chutes des prix, des systèmes de reconnaissance d’images capables d’identifier les personnes, des programmes de traduction automatique certes pas parfaits, mais assez efficaces pour reconstituer une majeure partie du texte à traduire, on trouve même des systèmes de reconnaissance de la parole et de synthèse vocale ainsi que de nombreux autres exemples. Cependant, toutes ces applications si étonnantes et intelligentes à vu d’œil, n’obéissent en réalité qu’un à un ensemble de mécanismes préprogrammés de telle façon à laisser place à peu d’adaptation dans la prise de décisions du logiciel/machine.

Il faut toutefois noter que, même si on est encore loin du scénario catastrophe « Asimovien » (où les machines ont des sentiments, peuvent se reprogrammer toutes seules, et décider de détruire l’humanité), cela ne veut en aucun cas dire qu’il n’est pas réaliste, et beaucoup de penseurs et de chercheurs, appellent à se préparer dès maintenant à faire face à de telles possibilités.

Une lettre ouverte prévue à cet effet a été rédigée par le FLI (The Future of Life Institute), une organisation non lucrative regroupant plusieurs scientifiques-chercheurs reconnus, dont le professeur Hawking. Le but de cette lettre est de restructurer les priorités de la recherche sur l’intelligence artificielle et des nombreux domaines qui y sont liées, de sorte à faire que les futurs systèmes intelligents soient robustes, sécurisés et maximisent les bénéfiques économiques et sociales. « Les systèmes intelligents doivent faire ce que nous voulons qu'ils fassent », peut-on lire dans le document. « Nous ne pouvons pas prédire ce que nous pourrions accomplir avec l’intelligence artificielle […] il est important de rechercher la façon de récolter ses avantages tout en évitant les pièges potentiels ». Ceci implique d’étudier les pires scénarios possible, mais aussi les meilleurs ; « l'éradication de la maladie et la pauvreté ne sont pas insondables », déclare le FLI.

Cette initiative accueillie avec enthousiasme dans la communauté scientifique offre un regard plus optimiste de l’impact de cette science sur l’avenir des êtres humains. La lettre a été approuvée et signée par des milliers d’industriels et de scientifiques dont les plus grands chercheurs du MIT, Oxford, Harvard, Stanford et Cambridge, mais aussi Google, IBM, Skype et Facebook ainsi que des centaines de programmeurs, intellectuels et étudiants à travers le monde.

Mais revenons un peu aux bénéfiques économiques et sociales cités ci-haut. Que pourrait donner cela en court et moyen terme ? Les machines remplacent peu à peu les êtres humains dans l’industrie parce qu’elles sont plus rapides, plus productives, mais aussi plus précises. Cela pourrait faire augmenter le taux de chômage, selon certains, qui constatent qu’actuellement, les chaines de montage des usines sont majoritairement robotisées et beaucoup de techniciens perdent leurs emplois. L’avis des chercheurs est toutefois partagé concernant cette inquiétude : un récent sondage américain avec la participation de plus de 1800 scientifiques avait montré que 48% d’entre eux sont pessimistes alors que 52% sont persuadés que l’impact de la robotique permettra de créer de nouvelles perspectives pour l’homme, avec l’apparition de nombreux sous-domaines et spécialités qui crée de nombreux emplois liés à ce secteur. On remarque en effet déjà la nécessité d’un large éventail de techniciens, d’ingénieurs et de programmeurs pour la modélisation, la réparation et la maintenance de ces machines.

En tout cas, tout le monde semble d’accord que les institutions éducatives actuelles ne préparent pas adéquatement les gens pour les compétences qui seront nécessaires dans le marché de l'emploi de l'avenir. Plusieurs universités, par exemple, proposent des cours en lignes gratuits et ouverts à tout le monde, généralisés ces dernières années sous le terme MOOC (Massively Online Open Classroom). Ils seraient une solution efficace pour combler ses lacunes et/ou apprendre de nouvelles compétences, mais ne peuvent en aucun cas remplacer un cursus universitaire avec un bon stage pratique selon les spécialistes de l’éducation.

En attendant, la recherche sur l’intelligence artificielle avance rapidement et nous surprend chaque jour avec de nouveaux domaines d’application.

Source : Lettre ouverte The Future of Life Institute, Sondage Pew Research, BBC News

Et vous ?

Que pensez-vous de la lettre ouverte du FLI ?

Que pensez-vous de la lettre ouverte du FLI ? L’homme pourra-t-il trouver un plan de secours au cas où les machines prendraient le dessus ?

L’homme pourra-t-il trouver un plan de secours au cas où les machines prendraient le dessus ? Que pensez-vous de l’impact économique à court terme de l’IA ?

Que pensez-vous de l’impact économique à court terme de l’IA ?

Vous avez lu gratuitement 676 articles depuis plus d'un an.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.