La ligne de code est-elle la meilleure unité de mesure d'un projet informatique ?

La ligne de code est-elle la meilleure unité de mesure d'un projet informatique ? Un diagramme les classe suivant l'importance de leur code source

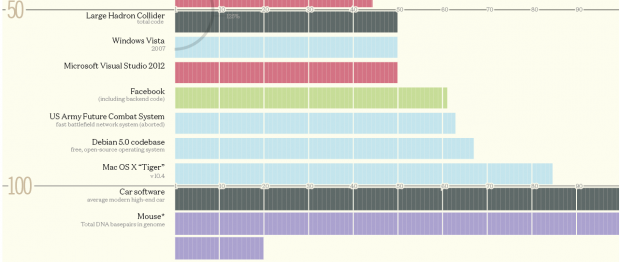

L'infographiste David McCandless a publié un diagramme classant les logiciels informatiques et les sites web suivant l'importance de leur code source, du plus petit nombre de lignes de code (un simple jeu pour iPhone) au plus important (le site web healthcare.gov).

Pour réaliser ce travail, il s'est inspiré de diverses sources parmi lesquelles la NASA, Quora, Ohloh ou encore des rapports de presse. Cinq catégories sont représentées par des couleurs différentes pour différencier les systèmes d'exploitation, les jeux vidéo, les applications, les navigateurs web et les machines. Des arcs ont également été apposés pour montrer l'évolution du code à travers le temps (comme le noyau Linux, Windows ou encore Microsoft Office).

Le diagramme révèle par exemple que le nombre moyen de lignes pour réaliser une application iPhone se compte en centaines de milliers. Avec plus de 50 millions de lignes de code pour sa plateforme, le réseau social Facebook est classé devant des systèmes d'exploitation comme Windows 7 ou Windows XP, qui requièrent chacun un peu moins de 40 millions de lignes de code.

La ligne de code est un indicateur. C'est un élément, parmi d'autres, qui est souvent employé pour quantifier l'effort qui sera exigé pour développer un programme informatique, ainsi que pour estimer la valeur d'un logiciel produit.

A comparer les codes

| Code : | Sélectionner tout |

var result = methodOne(methodTwo(a, methodThree(b)), c, d);

et

| Code : | Sélectionner tout |

1 2 3 | var result3 = methodThree(b); var result2 = methodTwo(a, result3); var result = methodOne(result2, c, d); |

| Code : | Sélectionner tout |

for (i=0; i<100; ++i) printf("hello"); /* Ici 1 ligne de code */| Code : | Sélectionner tout |

1 2 3 4 | for (i=0; i<100; ++i)

{

printf("hello");

} /* Ici 4 lignes de code */ |

Et vous ?

La ligne de code est-elle la meilleure unité de mesure d'un projet informatique ?

La ligne de code est-elle la meilleure unité de mesure d'un projet informatique ? Quelle est, selon vous, la meilleure unité de mesure possible ?

Quelle est, selon vous, la meilleure unité de mesure possible ?

Vous avez lu gratuitement 0 articles depuis plus d'un an.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

).

).