Envoyé par

stardeath

contredire, c'est pas moi qui apporte un truc qui veut tout et rien dire en l'imposant comme vérité absolu et indiscutable.

moi je dis que bloquer 1% de sites légitimes ou autoriser 1% de sites vérolés c'est du pareil au même, tu pourras trouver autant d'argument pour ou contre les 2.

Le fait même que le paradoxe des faux-positif existe invalide le raisonnement car on a alors un contre-exemple. Les données ne sont alors pas exploitables sans données complémentaires.

Ne pas la prendre en considération, c'est envoyer des milliers d'innocents en prison pour un assassin sous prétexte que la méthode trouve 80% des assassins et ne donne que 1% de faux positifs sur la population globale ( mais 99,9% des alertes sont des faux-positifs car les assassins représentent X% de la population globale).

De même pour le navigateur, si un blocage à 99% de chances d'être un faux-positif, il sera alors très vite ignoré ou désactivé par les utilisateurs par habitude le rendant totalement inefficace.

Envoyé par

stardeath

tient donc, et depuis le début je demande un exemple d'études objectives et exhaustives, j'attends toujours ...

C'est du niveau lycéen de faire de telles études :

- tu prends des boîtes de pétri identique ;

- tu met une culture de bactérie dedans (même quantité pour chaque boîte) ;

- tu prend le même sel que tu verse à des quantité différente sur les boîtes de pétri sauf sur une boîte (boîte témoin) ainsi qu'une autre où tu met des petites billes de plastiques (boîte témoin 2) ;

- tu les met dans un placard prévu à cet effet (protégé de la lumière directe du soleil, environnement "neutre", etc. ) ;

- tu renseigne toutes les conditions de l'expérience (durée, sel utilisé, type de culture, les boîtes de pétri utilisé, température moyenne (?), manipulations effectuées, etc. ) ;

- tu regardes régulièrement au fil des jours l’évolution de tes cultures ;

- tu prends des photo régulières des boîtes ;

- tu regarde si le sel a un effet apparent quant au développement de tes cultures.

Envoyé par

stardeath

l'absence de lien entre alerte et sécurité est aussi à prouver dans ce cas.

Non.

Tu ne comprends pas les démarches scientifiques.

Une corrélation n'est pas "vrai tant qu'on a pas prouvé qu'elle était fausse".

Si tu dois utiliser une corrélation, tu dois la prouver.

Demande à n'importe quelle personne manipulant des BDD immense comment ils font pour établir les corrélations.

Envoyé par

stardeath

condition initiale différente => conclusion différente

Non, x = 0 n'est en aucun cas une condition initiale.

C'est une proposition que j'utilise sans la prouver pour te montrer le ridicule d'utiliser des corrélations non-prouvée dans un raisonnement et de demander aux détracteurs de prouver le contraire.

C'est bien à l'étude de démontrer que x = 0 pas à ses détracteurs de démontrer que x != 0.

Envoyé par

stardeath

tu y tiens à ta démarche scientifique, d'ailleurs en parlant de scientifique, tu n'as pas démontré non plus qu'il y en avait jamais de corrélation entre les 2.

si tu déclenche une alerte quand quelque chose te semble bizarre, le doute seul te permet de dire qu'il y a potentiellement un élément déclencheur, tu n'as aucune preuve de la réalité de cette cause, mais le doute et le principe de précaution te font le signaler, on ne sait jamais.

tout comme le contraire, ce n'est qu'un doute, pas de quoi s'inquiéter ... mais lequel des 2 est le bon comportement?

Tu mélanges tout. Le principe de précaution n'a rien à voir avec le fait de prouver si une proposition est vrai ou est fausse. Mais dès qu'un risque existe, et si la corrélation n'est ni confirmée, ni infirmée, le principe de précaution fera qu'on considérera la chose comme "dangereuse" mais la corrélation ne sera toujours ni prouvée, ni infirmée.

Ensuite, ce n'est pas à moi de prouver l'absence de corrélation entre les deux éléments mais à l'étude de prouver la corrélation entre ces éléments. Si la corrélation n'est pas prouvée, le raisonnement ne tient pas.

Ensuite, je n'ai pas besoin de prouver l'absence de corrélation, juste à trouver un argument soulignant que la corrélation n'est pas évidente ce qui a déjà été faite.

Envoyé par

stardeath

mais puisque je sens que tu y tiens, je vais répondre, à quoi annoncer une conso cpu de 10% moindre si finalement tout le monde s'en fout, tout comme l'espace entre les bandes blanches.

Je te montre des exemples pour te faire comprendre le ridicule de ton raisonnement.

Envoyé par

stardeath

à quoi ça sert d'avancer ce nombre 10% si finalement on peut pas le critiquer sur la pertinence de l'avantage ou de l’inconvénient que cela amène?

Critiquer pour critiquer, ce n'est que du pinaillage ou du troll.

Critiquer un chargement de page qui va 50% plus rapidement parce que ces améliorations ne sont pas visible, c'est du troll. Cela peut être utile pour certains robots de recherches par exemple. Si tu ne trouve pas qu'une amélioration t'es utile, ce n'est pas pour autant qu'elle est inutile aux autres.

Ensuite, pour le CPU/GPU, on peut demander confirmation à des membres plus expérimenté que moi dans le domaine, mais je ne pense pas que déporter les calculs graphiques du CPU vers le GPU puisse avoir des inconvénients significatifs. Et le GPU est bien plus rapide que le CPU pour les calculs graphiques.

Envoyé par

stardeath

pourquoi est ce que je ne pourrai pas critiquer ce nombre fantaisiste de 10% comme vous le faites avec cette étude de microsoft?

est ce que ça n'en fait que de la pub? à vous écoutez, oui. il n'y a jamais les conditions de l'expérience, c'est toujours une fourchette approximative d'un gain attendu, pas une expérience scientifique avec un protocole précis permettant de démontrer un gain identique à conditions initiales égales ou équivalentes.

Parce que ce chiffre de 10% n'intervient pas dans le cadre d'un communiqué d'étude (et n'a donc pas pour but de prouver quelque chose) mais d'être là à titre d'indicateur. Les lecteurs savent que ce chiffre va varier selon les ordinateurs mais il donne un ordre de grandeur.

Il ne prend donc pas nécessairement ses lecteurs pour des "naïf" alors qu'il annonce une hausse des performances comme tu l'affirmais.

Envoyé par

stardeath

tout comme l'étude de microsoft, la seule chose que vous avez réussi à montrer c'est que ce n'est pas vrai parce que c'est microsoft, et que les 10% sont fiable parce que c'est google. CQFD

Non, on a prouvé que le raisonnement de microsoft est bancal est faux. Les 10% ne sont que de moi, et là cela ne joue plus sur un raisonnement mais sur une "confiance" en la source.

Si je poste à propos d'un de mes projets que j'utilise 10% de CPU en moins, on ne va pas aller me demander des justifications et je ne prend pas mes lecteurs pour des "naïfs".

Ensuite, on ne croit pas microsoft "parce que c'est microsoft" ? Ou n'est-ce pas plutôt que, à l'image de cette étude, microsoft perd tout crédit ?

Envoyé par

stardeath

et le jour où il se fera avoir, il regrettera.

Donc tu es d'accord avec moi, il n'y a donc pas de sécurité supplémentaire.

Envoyé par

stardeath

il y a 2 stratégies :

- on bloque un maximum, quitte à avoir des faux-positifs

- on essaie de bloquer un minimum les sites valides, quitte à laisser passer des trucs dangereux

les 2 stratégies ont des inconvénients :

- même si on bloque, des trucs dangereux peuvent toujours contourner

- on risque tout de même de bloquer des trucs valides

est ce qu'il y en a une de mieux que l'autre? pour moi non, par contre vu la politique des stores, leurs fréquentations et leurs critiques, je doute que les gens choisissent la deuxième.

C'est une question de proportion.

Mais il vaut mieux ne bloquer que 1% des menaces que d'avoir une technique qui aurait trop de faux-positifs rendant ainsi le dispositif inutile et ne bloquant au final 0% des menaces car l'utilisateur l'a désactivé ou l'ignore. Si je te montre un petit message à chaque action, combien de temps te faudra-t-il pour fermer ce message sans le lire complètement par habitude ?

1

1 |

0

0 |

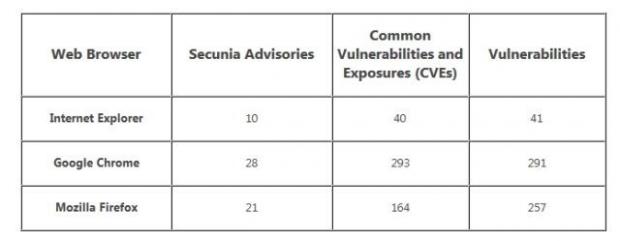

Internet Explorer 10 moins vulnérable que ses concurrents

Internet Explorer 10 moins vulnérable que ses concurrents Que pensez-vous de la sécurité d'Internet Explorer 10 ? Et de ces études ?

Que pensez-vous de la sécurité d'Internet Explorer 10 ? Et de ces études ? Utilisez-vous Internet Explorer 10 ou envisagez-vous de migrer sur le navigateur ?

Utilisez-vous Internet Explorer 10 ou envisagez-vous de migrer sur le navigateur ?

)

)